9. Dezember 2020

Liquid Tank #5 – Sexist AI? Wie Diskriminierung in den Algorithmus kommt

Was haben algorithmischen Systeme mit Diskriminierung zu tun? Und was können wir tun, um diskriminierende Strukturen durch Algorithmen zu erkennen und ihnen entgegen zu wirken?

Um diese Fragen ging es in unserem fünften Liquid Tank mit Michael Puntschuh vom iRights.Lab. Michael betreut bei iRights.Lab das Projekt „Algo.Rules“ und ist Teil des Teams Forschung & Projekte. Er beschäftigt sich mit digitalen Menschenrechten, Internet Governance und anderen ethischen, sozialen und rechtlichen Fragen digitaler Technologien. Damit ist er genau der Richtige für unseren Liquid Tank #5 zur Mittagspause.

Los ging’s mit einem anschaulichen Vortrag von Michael zu den Grundlagen algorithmischer Systeme und der Diskriminierung, die aus ihnen hervorgehen kann. Anschließend diskutierten die Teilnehmer:innen in kleineren Gruppen, um dann einige spannende Fragen und Ideen in großer Runde zu besprechen. Ihr habt die Veranstaltung verpasst oder wollt noch einmal reinschauen? Den Vortrag von Michael haben wir für euch aufgezeichnet.

Diskriminierung durch Algorithmen, das klingt erst einmal abstrakt. Aber wir alle können davon betroffen sein ohne es zu merken, merkte Carolin von Liquid Democracy gleich in ihrer Einleitung an. Denn genau da liegt das Problem Algorithmen-vermittelter Diskriminierung, wie sich im Laufe von Michaels Vortrag zeigen sollte: sie ist erst schwer erkennbar und dann schwer nachweisbar.

Aber wie funktionieren algorithmische Systeme eigentlich? Und warum kann es zu Diskriminierung kommen, wenn sie eingesetzt werden? Michael erklärte uns dies an einem Beispiel. Nehmen wir an, ein Unternehmen will eine Software nutzen, um Bewerbungsprozesse zu vereinfachen und zu beschleunigen. Hier gibt es zwei Optionen: Ein nicht-lernende algorithmisches System würde nach vorgegebenen Auswahlkriterien (z.B. einer bestimmten Abschlussnote), die Bewerbungen sortieren. Ein lernendes System erkennt Muster in einem Trainingssatz von Daten, „lernt“, was eine erfolgreiche von einer abgelehnten Bewerbung unterscheidet und formuliert daraus „eigene“ Regeln. Bei beiden Abläufen kann es zu Diskriminierung kommen.

Doch das selbstlernende algorithmische System ist sehr viel schwerer zu durchleuchten. Amazon setzte zum Beispiel solch ein System für einige Jahre ein. Das Problem: In dem Datensatz aus den erfolgreichen Bewerbungen der letzten 10 Jahre, der als „Training“ fungierte, gab es diskriminierende Muster, wie beispielweise eine Überrepräsentation von Männern, die das System dann replizierte. Damit wurden aber zum Beispiel auch Bewerbungen mit sprachlichen Ausdrücken, die eher von Männern verwendet werden, bevorzugt.

Um dem entgegen wirken zu können, ist es zunächst wichtig, diskriminierende Muster in algorithmischen Systemen zu erkennen. Algorithmen-vermittelte Diskriminierung geschieht indirekt auf Basis von „Ersatzidentitäten“ (z.B. gibt es keine direkte Bevorzugung von Männern, sondern von Bewerber*innen mit bestimmten Merkmalen) und kann gleichzeitig auch intersektional stattfinden.

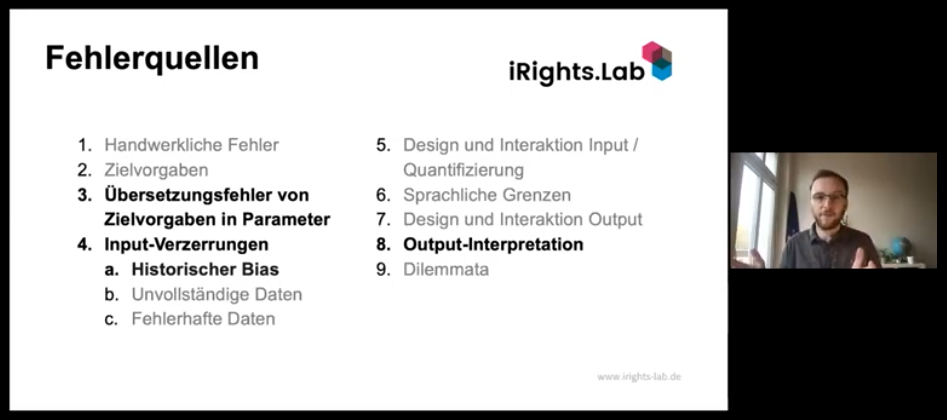

Deshalb sollten die Fehlerquellen dieser Systeme genauer untersucht werden. Gibt es diskriminierende Strukturen aufgrund von diskriminierenden Mustern im Datensatz? Wurden die Zielvorgaben falsch in die Parameter übersetzt? Werden die Daten, die am Ende vom System ausgegeben werden, hinterfragt oder direkt umgesetzt? Fehlerquellen zu kennen ist wichtig, denn genau hier können Lösungsstrategien entwickelt werden.

Um Lösungsstrategien ging es dann auch in der gemeinsamen Diskussion. Laut Michael gibt es zwei Wege: entweder wird versucht ethisch „gute“ Systeme zu entwickeln oder der Entwicklungs- und Gestaltungsprozess der Systeme liegt im Fokus. Aus einer Breakout-Gruppe wurde die Frage nach transparenter KI gestellt. So könnte zum Beispiel offengelegt werden, wenn Algorithmen in Entscheidungsprozessen eingesetzt werden oder auf welcher Basis bestimmte Entscheidungen vom System getroffen werden. Eine Teilnehmerin schlug vor, die Four-Fifths-Rule zum Nachweis von Diskriminierung zumindest als Übergangslösung bei algorithmenbasierten Selektionsprozessen zu nutzen. Es bleibt „ein Thema mit viel Zukunftsmusik“, bei dem Lösungsansätze aus der Forschung schneller in der Praxis aufgenommen müssen, wie Michael betonte.

Wir haben aber auch gelernt: lernende algorithmische Systeme können bestehende diskriminierende Muster explizit machen. Denn Algorithmen-vermittelte Diskriminierung ist trotz allem „menschengemacht“ und bezieht sich letztlich immer auch auf existierende Verhältnisse in der Gesellschaft. Und ist damit auch ein weiter Grund für mehr Diversität in der Softwareentwicklung.

Danke, dass ihr so zahlreich teilgenommen habt! Wir haben uns sehr über eure vielen spannende Fragen, Gedanken und Anregungen gefreut. Und das in eurer Mittagspause!

Im Februar geht es weiter mit unserem nächsten Liquid Tank. Um rechtzeitig von unseren Events zu erfahren und neuen Input zu digitaler Demokratie zu bekommen, abonniert unseren Newsletter.

Ihr habt Feedback zum Liquid Tank oder Vorschläge, wen wir als nächstes einladen sollen? Besucht uns auf adhocracy.plus/liquid-tank/ oder schreibt uns unter hallo@liqd.net